seo没死!那些说 SEO 已死的人,要么是不愿意接受现实的变化,要么是对 SEO 理解不够深入。

如果你是 SEO 新人,光听演讲、参加活动、社交,是学不会 SEO 的;你得动手去做、去实操、去建站,否则学到的知识都是纸上谈兵。

由 Google Search 团队举办的一场非常特别的大会:Google Search Central Live Deep Dive Asia Pacific 2025。。整整三天!

规模之大,议程的紧凑程度,嘉宾阵容之深(Google官方员工 + 外部企业的SEO讲师),及参会者数量,无论哪个维度,这个大会都属行业首次!

不唠叨,直接上干货!以下是我整理的一些笔记和收获(不分先后顺序)。

注:我笔记的原文是英语(并分享到了我的LinkedIn),下面的内容是通过 ChatGPT 翻译、手工审核并微调后的输出,严格的说,本文也算是 AI 内容,但人工成分(human efforts)很高,要是 Google 人工质量评估员来打分,应该不会被标成 low quality 🙂

1)“SEO 没有死” – 来自 Gary Illyes

来自Google搜索发言人 Gary Illyes的演讲PPT

从搜索引擎诞生的那一刻起,SEO 就从未死亡,它只是一直在进化。

现在的 SEO ≠ Search Engine Optimization(搜索引擎优化),而是 Search Experience Optimization(搜索体验优化)或 Search Everywhere Optimization(全场景搜索优化)。

那些说 SEO 已死的人,要么是不愿意接受现实的变化,要么是对 SEO 理解不够深入。

2)世界一直在变

新平台 + 新用户偏好 + 新技术,正在加速一切改变。

你过去的成功,并不能保证未来还会成功。

要么进化,要么淘汰!

3)人类的好奇心不会消失

只要人类对世界保持好奇,搜索市场就一直存在。

谁说年轻人不搜索?Google 的数据显示,Z 世代(18-24 岁)是每天搜索量最大的群体!

4)搜索仍在增长,但也在变化

搜索词变得越来越长、越来越复杂。

10 年前,大多数人搜索的是 5 个词以内的短语,但现在不一样了。

复杂的长尾词(或句子),之于 Google 或者我们 SEO 人,挑战和机会兼备!

5)GEO / LLMO / AEO / AISEO(随你怎么叫)本质上还是传统 SEO

图片来自Google的另一位搜索部门员工 Cherry Prommawin

Google 的 AI 模式、AI Overview、Gemini 等新功能,底层的逻辑跟传统的搜索是一样的(爬取、索引、排序这三大块)。

没必要为 AI 或大模型特地去做优化,只要继续做好你擅长的传统 SEO 就好。

6)让 AI 为你所用,而不是你被 AI 驱使

AI 是很强大的工具,但也容易产生“幻觉”(hallucination),尤其是在用它生成内容大纲时。

要确保你的内容里有独特的价值,而不是全网总结的“炒冷饭”,还记得信息增量(information gain)这个概念吗?

Google 前几年对此还向美国专利局申请了一项专利,能计算互联网上新发布页面内容的信息增量分数。

7)你应该用 AI,但要负责任地使用

Google 强调,AI 可以用来协助内容创作,但务必要小心、负责任地用,始终要有人工审核 AI 生成或辅助的内容后再发布。

8)Google 评估内容质量的四大维度

Effort(努力):内容中体现了多少人工的成分?

Originality(原创性):是否提供了新的、独特的信息?(再次提醒“信息增量”)

Talent or Skill(专业能力):作者是否有足够的专业知识或技能?

Accuracy(准确性):是否有事实错误?

9)E-E-A-T 不是排名信号!

Google 的这个说法可能会让人产生误解,事实上,他们的意思是:E-E-A-T 只是搜索质量评估员评估 SERP 页面的一个参考指标,而不是直接参与排名的算法因子。

不过,这不代表内容的质量和可信度不重要,恰恰相反,它们仍然很关键。

小提示:E-E-A-T 中最重要的是 “Trust(可信度)”。

10)Google 能否识别页面的 AI 内容?

这是现场一位参会者的提问,Google 一位发言人的原话是:“we try not to.”

然后解释说他们有其他衡量内容质量的算法系统,意思是,就算不去做 AI 度识别,他们依然可以判断该页面内容的质量高低。

We try not to(我们尽量不去)。。 这个回答比较圆滑,并没有正面回答参会者的问题,我认为 Google 发言人的意思是:we (can but we) try not to(括号里的字省去了)

这里有两层意思:

一、Google 绝对有能力识别一个页面的 AI 内容痕迹或水印(这点应该毋庸置疑);

二、Google 尽量不去做这个识别,可能没必要,可能“烧钱”增加计算成本。

第二层意思的“尽量”就比较耐人寻味了,Google 到底有没有对抓取和收录的内容进行 AI 痕迹识别,这个估计(除了算法工程师)谁也不知道。

我个人的看法是:对于超级重要的行业或关键词(比如 YMYL 类),或者部分网站(页面数量庞大的网站),Google 可能会选择性的对其内容进行 AI 检测看是否有超标的嫌疑。

11)目前 SERP 上排名靠前的页面内容,大多是人工创建(而非 AI)

Google 的观察发现,真正优质并排名靠前的内容,大多数仍是人工撰写的。

注意:这非并说 AI 内容不能获得排名,也不意味着只要人写的内容就一定排名好。

12)AI 内容即使排版再好再美观,没有人工成分,它依旧是低质量内容

因为这些内容缺乏人工的介入,参见上述第8条关于内容质量的四大评判标准。

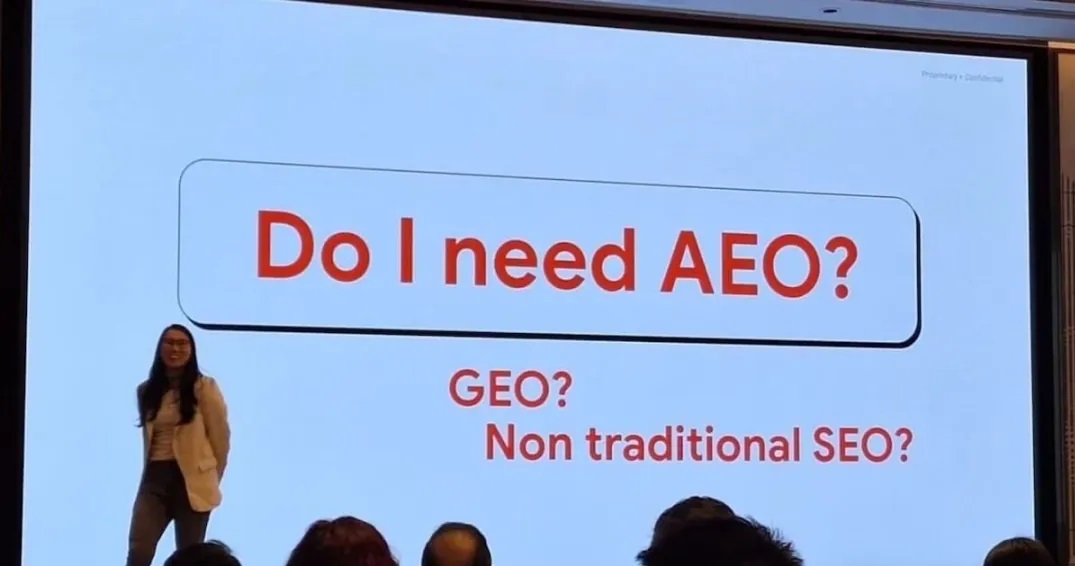

13)站长不仅要关注排名信号(ranking signal),也要重视索引信号(indexing signal)

页面不被索引,就无法排名!

Google 所说的“索引信号”包括:国家、语言、HTTPS 安全协议、Core Web Vitals、Dofollow 外链、HReflang 标签、内容时效性、是否违反垃圾政策等。

但以下不是索引信号:域名历史、结构化数据、XML sitemap、页面可爬取性、内链、内容可读性、话题权威、内容深度与完整度、是否匹配搜索意图、关键词是否出现在 H1 标签、E-E-A-T 等。

来自Google官方的PPT,注:Hreflang Tags 应该是 yes(Gary Illyes 后来解释说弄错了)

14)页面数低于 1000 的网站一般无需要担心爬取预算

自从 AI 爆发以来,互联网每天充斥着大量垃圾内容,Google 因此也在重新评估各网站的爬取预算(crawl budget)。

很多年前,10 万页面以上被认为是大型网站,再后来是 1 万页,现在,这个门槛可能还在降低。

注意:只有状态码为 2xx、3xx、429、5xx 的页面才会占用爬取预算,4xx 的不会。

15)使用 LLM.txt 会帮助 Google 更好地索引或 Gemini 展现吗?

不会,Google 只看 robots.txt。

16)Search Console 是处理技术端 SEO 的最好帮手,但它并不完美

Google 花了很多精力在 Search Console 这个产品上,不断推出新功能、优化使用体验,帮助站长和 SEO 人更好地理解和管理网站。

不过它也不是万能的,你仍需要确保 Google 能如你所愿地“看见”你的网站。

17)Google Trends 是被低估的 SEO 神器

它不仅可以用于寻找热点趋势、关键词研究,还能帮助优化内容策略。

就在本次大会,Google 团队还官宣了这条消息:Google Trends 开放了 API!

更方便我们做 SEO 自动化,解锁更多 SEO 高阶用法。

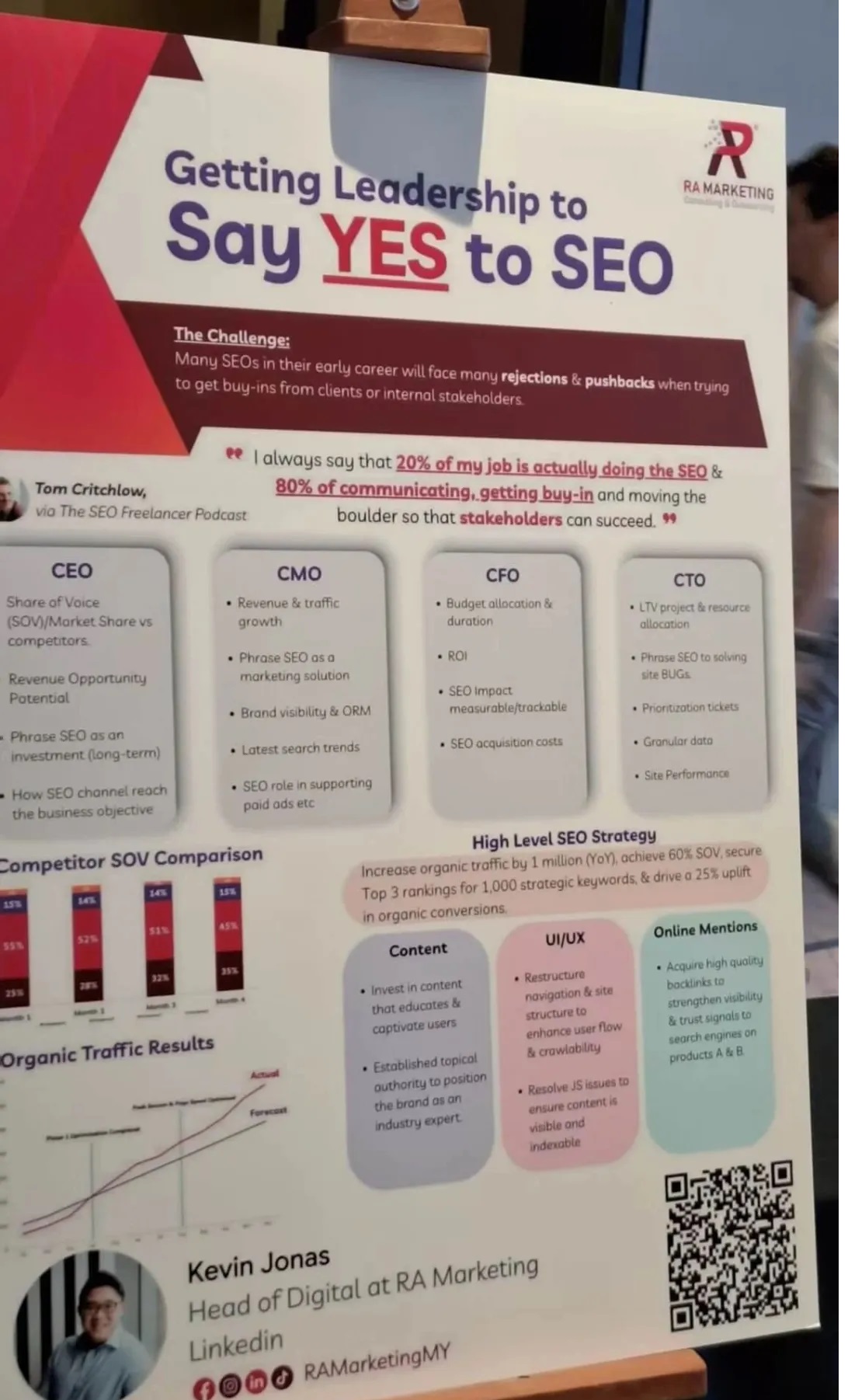

18)说服领导(CEO、CMO、CFO、CTO)支持 SEO 并不容易,但有方法

Kevin Jonas 分享了很多实用的沟通技巧和角度,让管理层说 YES 更容易。

我发现他的海报非常实用,所以也贴出来跟大家共享。

来自Kevin Jonas的海报,抱歉,拍照角度不好(当时现场人很多)

以上就是SEO没死!这18条关键笔记让你深层理解SEO的全部内容了,希望能够帮助到你,找热门资讯记得来极光资源网!